«L’intelligenza artificiale può portare grandi benefici, ma può anche segnare la fine dell’umanità», ha detto lo scienziato Steven Hawkings. Verità o catastrofismo?

Dal 2014 quando pronunciò questa frase, sono passati 10 anni. La comunità tecnologica e scientifica ancora oggi continua a riconoscere sia i benefici che i rischi dell’IA, e a discutere su come mitigare questi rischi senza frenare l’innovazione. Ma cos’è successo nel frattempo? L’automazione guidata dall’IA è già entrata a gamba tesa nelle nostre vite e sta trasformando il mercato del lavoro e la nostra società. Robot avanzati che migliorano l’efficienza e riducono il rischio umano, chatbot e assistenti virtuali, riconoscimento facciale per la sicurezza, algoritmi di apprendimento per diagnosticare malattie, assistenti virtuali come Siri e Alexa, auto senza conducente, piattaforme educative personalizzate sono solo alcune delle applicazioni dell’IA che stanno rivoluzionando il modo in cui viviamo.

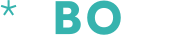

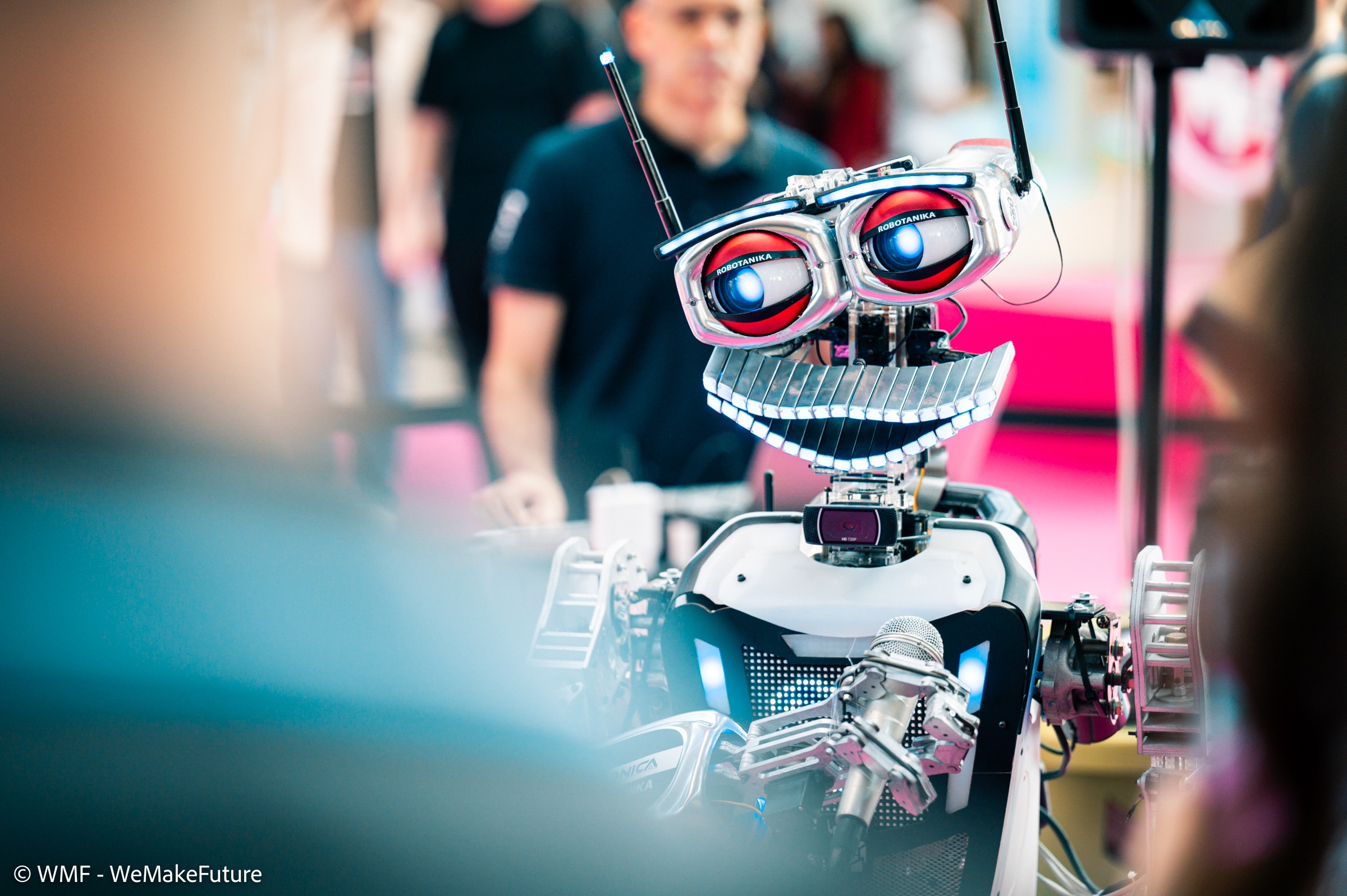

Dal 13 al 15 giugno a Bologna si svolgerà l’evento internazionale We Make Future, il festival di Search On Media Group che esplorerà le principali tematiche di innovazione digitale e sociale, con oltre 100 eventi formativi, di business e intrattenimento. Una piattaforma dove arte, cultura, musica, spettacolo, affari e networking si fondono in un unico evento con la presenza di oltre 1.000 speaker da tutto il mondo.

Oggi parleremo con uno di loro, Alessio Pomaro, Head of Artificial Intelligence (AI) di Search On Media Group, ingegnere informatico, docente dell’Università di Parma e dello IUSVE.

Ormai moltissimi studenti usano le app per fare i compiti: come può l’IA contribuire al futuro della formazione e dell’educazione culturale?

«Inizialmente, quando iniziarono a diffondersi tecnologie basate sull’AI generativa come ChatGPT, la reazione fu quella di imporre dei blocchi. Alcune scuole iniziarono a ragionare su come impedire agli studenti di usare questi sistemi, per proteggerli dalla dipendenza, dall’atrofizzazione della capacità di ragionamento, dalla potenziale non comprensione del valore dell’educazione, dalla riduzione di competenze interpersonali.

Tuttavia, io credo che la chiave non sia un blocco rigido, ma un’educazione digitale che coinvolge istituzioni, famiglie e scuola, con due obiettivi:

- aiutare i ragazzi a capire come questi nuovi strumenti possono aiutarli nella crescita formativa, potenziando le loro capacità;

- sviluppare negli studenti una cultura sul funzionamento di questa tecnologia, in modo da sviluppare la capacità di pensiero critico.

Parallelamente, è necessario che la scuola adegui le metodologie, consapevole di questi nuovi strumenti. Esistono proposte interessanti di utilizzo dell’AI generativa come strumento di affiancamento di studenti e insegnanti nel percorso formativo. Il progetto di Sal Khan, ad esempio, che viene raccontato nel suo TED talk: si tratta di una piattaforma per l’istruzione, in cui gli studenti studiano e si esercitano, assistiti e stimolati da un tutor personale basato sull’AI generativa. Un tutor che non dà risposte, ma stimola il ragionamento, e corregge gli errori degli studenti. Il tutto con la supervisione degli insegnanti, che possono monitorare costantemente tutta l’attività».

Con le giuste precauzioni, l’AI può essere utilizzata per rivoluzionare positivamente l’istruzione.

– Sal Khan

L’arte realizzata con l’IA può veramente essere considerata creativa? Quali sono le critiche più significative e quali le implicazioni etiche per le opere realizzate da artisti che usano l’IA per replicare lo stile di altri artisti famosi?

«Gli algoritmi possono aiutarci a uscire dai nostri schemi, perché possono agire (in determinati contesti) privi dei bias che ci condizionano.

Se questo rientra nel concetto di “creatività”, allora sì, l’AI può essere creativa. Questo aspetto è straordinario e facilmente comprensibile in ambito scientifico. Ma tutto sembra andare in “tilt” quando dal concetto di creatività scivoliamo nell’ambito artistico.

Propongo un esperimento: supponiamo che venga pubblicato un nuovo disco di Elvis Presley generato dall’AI. Tecnicamente migliore di tutti quelli creati dall’artista. I fan lo amerebbero? Probabilmente NO. Perché l’arte non è solo nell’estetica dell’output, ma è anche nella consapevolezza del percorso che fa giungere all’output.

Sul tema della replicazione di stili artistici, si innescano diverse questioni. Sui dati che vengono utilizzati in fase di training dei modelli generativi, ad esempio: quali dataset vengono utilizzati? Si stanno addestrando modelli usando dataset protetti da copyright senza il consenso degli autori? Altre questioni riguardano gli output stessi. Ad esempio: chi detiene i diritti su ciò che i modelli producono?

Queste e molte altre domande fanno parte di una parentesi tuttora aperta, e al centro di discussioni in tutto il mondo.È necessario fare chiarezza velocemente su queste tematiche, attraverso tavoli di discussione multidisciplinari, sviluppando nuovi sistemi di governance condivisi globalmente».

L’IA ha incominciato a influenzare i lavori che implicano routine e attività prevedibili, per esempio nei settori manifatturiero e amministrativo. Anche quelli creativi come giornalismo, copywriting, grafica hanno incominciato a utilizzarla per generare contenuti. Jack Ma, cofondatore di Alibaba ha detto che “l’IA aprirà la porta a lavori che non sappiamo ancora che esistono”. A fronte di un’integrazione sempre più pervasiva dell’IA nella nostra vita quotidiana e professionale, quali sono i lavori che verranno soppiantati e quelli nuovi che si stanno profilando? Come possono prepararsi i lavoratori ad affrontare le nuove sfide e opportunità?

«Ogni tecnologia dirompente, ogni innovazione, porta con sé dei cambiamenti, quindi possiamo aspettarci che questo riguarderà anche il mondo del lavoro. Ci saranno nuove professioni e altre, nel tempo, muteranno e/o scompariranno. Ripercorrendo la recente storia, chi avrebbe pensato 20 anni fa che si potesse vivere producendo video di YouTube, applicazioni mobile o siti web? Oggi, banalmente, ad esempio, ci sarà sempre più bisogno di esperti in grado di integrare questa nuova tecnologia nei processi aziendali. Servirà, in azienda, chi coordina questo tipo di evoluzione e chi si specializza nell’interazione con questi modelli. Esistono diversi studi che mettono in evidenza l’impatto che l’AI, inserita nei flussi di lavoro, sta impattando, e impatterà, settori e professioni. Come in ogni transizione, sarà fondamentale il monitoraggio e il controllo per garantire l’equilibrio.

Il consiglio che mi sento di dare oggi è quello di portare in azienda la cultura e la consapevolezza di questi sistemi, e di dare una “spinta al volano”. Perché chi conosce alla perfezione i processi interni, con queste nozioni a disposizione, è la figura perfetta per capire dove si potrebbero avere reali vantaggi».

Nel 2014 Val Kilmer, l’attore di The Doors e Batman Forever, ha perso la voce a causa di un tumore alla gola. Due anni fa per Top Gun: Maverick, grazie alla startup di IA Sonantic, che ha ricreato la sua voce a partire da vecchie registrazioni, l’attore ha potuto ritornare sullo schermo nell’iconico ruolo di Iceman. Mi potresti spiegare come funziona questa tecnologia e quali sono altre applicazioni innovative che stanno abbattendo le barriere linguistiche e trasformando la comunicazione?

«Praticamente tutte le Big Tech possiedono modelli molto evoluti in grado di clonare fedelmente le caratteristiche della voce di un essere umano. Mentre qualche anno fa servivano ore di registrazione per ottenere un buon risultato, oggi sono sufficienti delle manciate di secondi. La stessa OpenAI, ad esempio, ha recentemente presentato “Voice Engine“, il suo modello vocale, che permette la creazione di voci sintetiche personalizzate.

La clonazione vocale prevede la registrazione di una voce umana, che viene analizzata per comprenderne le caratteristiche uniche, ad esempio le sfumature di altezza, tono, inflessione e ritmo. Infine, un modello di intelligenza artificiale utilizza questa analisi per generare nuovo parlato con la stessa voce, anche frasi che l’oratore originale non ha mai pronunciato. Uno degli esempi più interessanti di utilizzo di questa tecnologia nella comunicazione riguarda la possibilità di registrare un video o un audio, generando automaticamente gli stessi output in qualunque altra lingua. È possibile, addirittura, ottenere il video tradotto con il lip-sync, ovvero con la sincronizzazione delle labbra dell’oratore nelle diverse lingue. Immaginiamo quanto questo impatterà nella diffusione della cultura a livello globale.

Per fare un altro esempio, possiamo spostarci nel mondo dell’assistenza clienti. Queste tecnologie permetteranno (e permettono già) di avere degli assistenti virtuali che rispondono ai clienti in diverse lingue, senza avere necessariamente la knowledge base tradotta in tutte le lingue.

Dando uno sguardo al futuro, inoltre, e tornando all’esempio della voce di Val Kilmer, probabilmente potremo avere dei sistemi che non solo trasformano il testo in parlato, ma che trasformano i segnali neurali in parlato (ECoG-to-speech). Un recente paper dal titolo A neural speech decoding framework leveraging deep learning and speech synthesis, pubblicato da Nature, ne descrive un’applicazione. Immaginiamo le applicazioni di queste tecnologie a supporto di deficit neurologici».

Oggi nel mondo digitale il sospetto della manipolazione è sempre dietro l’angolo, a danno della reale comprensione dei fatti. Facciamo un esempio: tre giorni dopo l’attacco di Hamas nei territori israeliani, su X sono circolate foto di corpi di bambini carbonizzati. Gli esperti avevano ipotizzato che le immagini potessero essere finte. A prescindere dalla veridicità, il solo atto di dubitare ne ha smorzato l’impatto emotivo. Le immagini si sono poi rivelate vere, ma c’è un ma. L’esistenza stessa dell’IA ha ulteriormente sbiadito il confine tra la realtà e la riproducibilità digitale e ha insinuato il dubbio su larga scala.

Di cosa abbiamo bisogno per sviluppare il pensiero critico e per difenderci dai “fake”?

«I rischi, in realtà, possono essere anche maggiori, rispetto a quelli descritti. Mi riferisco, ad esempio, al fatto che i contenuti “spazzatura” generati stanno entrando anche nelle ricerche scientifiche, e ne parla Gary Marcus in un recente post.

Io sono un sostenitore del fatto che, il primo passo per sviluppare il pensiero critico, sia quello di alzare il livello di “educazione digitale” che riguarda questi sistemi.

Se le persone fossero più consapevoli del funzionamento di un modello di linguaggio, forse non userebbe ChatGPT (o tecnologie simili) come sostituto di un motore di ricerca. Se fossero più informate sul concetto di deepfake e sul livello di accuratezza che già oggi è a disposizione, forse correrebbero meno rischi.

E questo vale principalmente per il momento storico che stiamo vivendo, che potremmo definire “di transizione”, in cui un chatbot dotato di uno dei modelli di linguaggio più potenti, è stato addestrato proprio grazie alle interazioni con milioni di persone. In un momento in cui, lo dicevamo anche precedentemente, abbiamo delle “parentesi aperte” da gestire.

Come ci si difende dai “fake”? Un ingrediente l’abbiamo già definito: la cultura. Secondo il mio punto di vista, ci sono altri due ingredienti principali.

Il primo è l’evoluzione tecnologica, messa al servizio dello sviluppo di “contromisure”. Di sistemi tecnologici in grado di tutelarci. Oggi, ad esempio, non esiste un metodo efficace per riconoscere un output generato dall’AI generativa, e credo che, con questi ritmi evolutivi, ci sarà ancora del lavoro da compiere prima di ottenerlo. Ma qualcosa sta nascendo: ottima, ad esempio l’iniziativa di YouTube e Meta che permetteranno l’etichettatura dei contenuti generati da algoritmi, nel momento in cui vengono caricati nelle piattaforme.

L’ultimo ingrediente principale, non può non essere la governance. Abbiamo bisogno di nuovi sistemi di governance, al passo con l’accelerazione tecnologica che stiamo attraversando, per garantire che questi sistemi vengano usati per migliorare la nostra condizione».

Solo 23 parole: ridurre il rischio di estinzione derivante dall’IA dovrebbe essere una priorità globale, al pari di altri rischi su scala sociale, come le pandemie e la guerra nucleare. Questo l’inquietante appello firmato l’anno scorso da 350 ricercatori ed esperti, tra cui anche Sam Altman, creatore di Chat GPT e Demis Hassabis, chief executive di Google DeepMind. Anche Steven Hawking e Elon Musk firmarono nel 2015 una lettera aperta che in sostanza parlava di grandi vantaggi ma anche dei rischi legati alI’IA.

Quali sono i principali vantaggi e rischi dell’IA?

«L’intelligenza artificiale è uno strumento molto potente, che ha la capacità di accelerare processi. Proprio per questo motivo va gestito con grande attenzione, perché la scelta dei processi da far accelerare, e i margini di manovra dello strumento, faranno una grande differenza. Dei rischi abbiamo già parlato in precedenza. E si manifesteranno se sceglieremo di accelerare processi come la disinformazione, la manipolazione, i bias, e i disequilibri sociali, senza un controllo adeguato in grado di garantire la sicurezza e la privacy delle persone.

I vantaggi, riguardano processi come il miglioramento della produttività, la ricerca scientifica orientata alla scoperta di farmaci migliori, di nuove cure, di nuovi materiali, di nuove tecnologie in tempi e con costi enormemente ridotti. In generale, processi orientati a migliorare la nostra condizione. Diciamo che la “cassetta degli attrezzi” è la stessa. Dobbiamo scegliere bene il “cantiere” in cui decideremo di usarla, e la regolamentazione che la riguarda».

I computer diventeranno più intelligenti di noi?

«I “computer”, di certo, diventeranno sempre più abili ad accelerare processi. Ma quando parliamo di “intelligenza” siamo su piani diversi. Di certo, il termine “intelligenza artificiale” non aiuta nella comprensione di questi aspetti.

Un modello di linguaggio, ad esempio, può essere talmente performante da darci perfettamente la sensazione di “comprensione” e “ragionamento” (e su questo ci siamo quasi), ma non ha basi logiche solide e affidabili. Recentemente ho pubblicato un piccolo esperimento. Ho chiesto a diversi modelli: “devo mettermi in contatto con l’unico fratello di mio fratello… come posso fare?”. Nessuno mi ha dato una risposta adeguata alla prima interazione.

Questi modelli ottengono punteggi impressionanti su molti benchmark, superano esami in modo più brillante della media delle persone, ma “cadono” su domande che richiedono ragionamenti che a chiunque sembrerebbero banali. Questo è un problema? No, se ne abbiamo la consapevolezza e li usiamo laddove possono darci dei reali vantaggi. Questo fa capire che questi sistemi, in un certo senso, si comportano in modo intelligente pur non essendo intelligenti. Gli algoritmi, se gestiti in modo adeguato, agiscono con successo, ma non hanno la capacità di agire con intelligenza per arrivare al risultato (come farebbe una persona). In futuro, come dicevo, i modelli diventeranno sempre migliori, le tecnologie miglioreranno per renderli più affidabili ed efficienti, ma rimarranno strumenti (sempre più potenti) in grado di accelerare processi.

“L’ultimo paradosso è che questa tecnologia può diventare il potente catalizzatore di cui abbiamo bisogno per riscoprire la nostra umanità”. Questa citazione di John Hagel offre lo spunto per una riflessione profonda. Non l’IA come una minaccia o un sostituto dell’essere umano, non solo come strumento di progresso tecnico ma proviamo a guardarla come un amplificatore delle nostre capacità. Per aprirci a nuove forme di collaborazione creativa tra umani e intelligenze artificiali».

A proposito, una di queste domande è stata scritta dall’IA. Indovinate quale?

Condividi questo articolo